NVIDIAがGeForce RTX GPUで動作する技術デモ「Chat with RTX」を無料でリリースしました。ユーザーはChat with RTXを独自のコンテンツでパーソナライズでき、システム要件はVRAMが8GB以上のRTX 30シリーズ以降のGPUを搭載したWindowsマシンとなっています。

Chat with RTX Now Free to Download | NVIDIA Blog

https://blogs.nvidia.com/blog/chat-with-rtx-available-now/

NVIDIA Brings Generative AI to Millions, With Tensor Core GPUs, LLMs, Tools for RTX PCs and Workstations | NVIDIA Newsroom

https://nvidianews.nvidia.com/news/generative-ai-rtx-pcs-and-workstations

Chat with RTXはRetrieval-Augmented Generation (RAG)、TensorRT-LLM、NVIDIA RTXのアクセラレーション技術を用いて、Windows PC上にローカルで生成AIを動作させます。ユーザーはPC上のローカルファイルをデータセットとして、MistralやLlama 2のようなオープンソースの大規模言語モデルに迅速かつ簡単に接続できるとのこと。

以下のムービーで、Chat with RTXがどのように動作するのかを見ることができます。

Create A Personalized AI Chatbot with Chat With RTX - YouTube

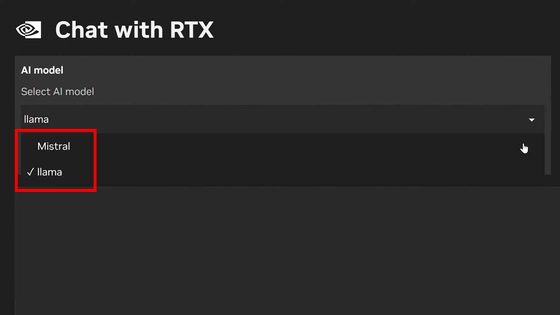

Chat with RTXで使用できるAIモデルはMistralとLlama 2の2種類。

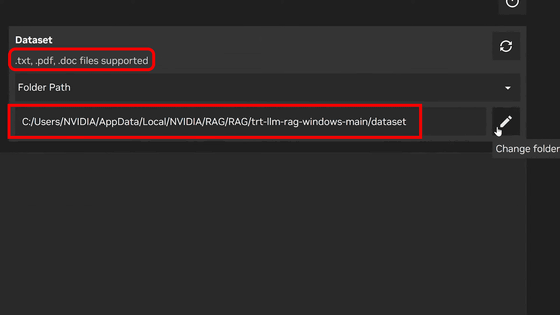

データセットにローカルフォルダ内のファイルを指定可能。テキストファイルのほか、PDF形式やDOC形式もサポートしています。

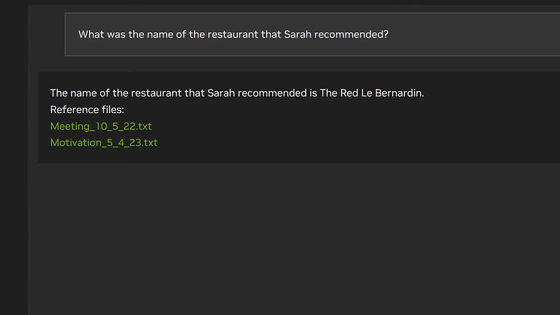

Chat with RTXに「サラがおすすめしていたレストランの名前は何?」と質問したところ、データセット内にある会議ログなどのテキストファイルを参考にレストランの名前を教えてくれました。

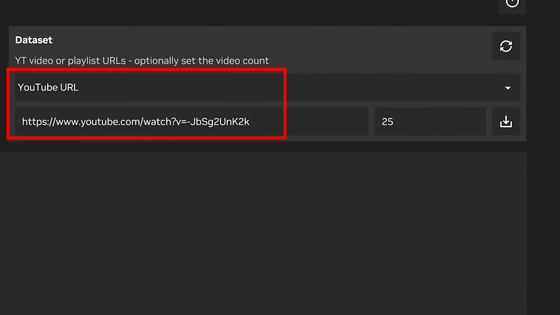

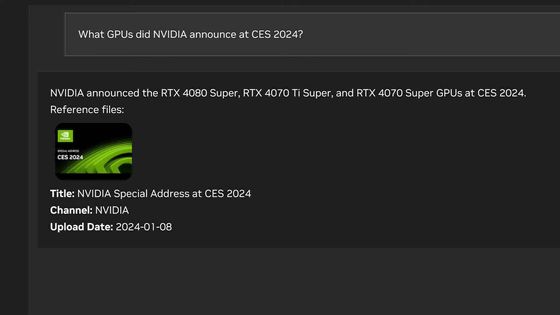

また、データセットにYouTubeのURLを指定することもできます。ムービーでは、CES 2024におけるNVIDIAの発表動画のURLが入力されています。

「CES 2024でNVIDIAはどんなGPUを発表した?」と質問したところ、Chat with RTXは動画の内容から「NVIDIAはRTX 4080 Super、RTX 4070 Ti Super、RTX 4070 Superを発表しました」と回答しました。

Chat with RTXを使うことで、手元にある長い議事録をChat with RTXにまとめさせたり、PDFファイルに書かれている内容から検索したい事項だけを抽出したりすることが可能になります。

なお、Chat with RTXは、少なくとも8GBのVRAMを備えたGeForce RTX 30シリーズ以降のGPUが必要で、さらにOSはWindows 10/11、さらにバージョン551.52以降のNVIDIA GPUドライバーが要件となっています。記事作成時点だと日本向けはまだリリースされておらず、以下からリリース開始の通知を設定できます。

Chat With RTX を使用してカスタム LLM を構築する |エヌビディア

https://www.nvidia.com/ja-jp/ai-on-rtx/chat-with-rtx-generative-ai/

この記事のタイトルとURLをコピーする

からの記事と詳細 ( 無料のチャットボットAI「Chat With RTX」をNVIDIAがリリース、GeForce RTX GPU搭載PCでローカル動作が可能 - GIGAZINE(ギガジン) )

https://ift.tt/xFkI0X2

科学&テクノロジー

No comments:

Post a Comment