米Appleは5月16日(現地時間)、認知、音声、視覚、モビリティのアクセシビリティを支援する複数のツールを発表した。年内に提供を開始する計画だ。Appleはプレスリリースで言及していないが、「iOS 17」「iPadOS 17」の機能とみられる。

声を出せない人でも音声で会話に参加できる「Live Speech」

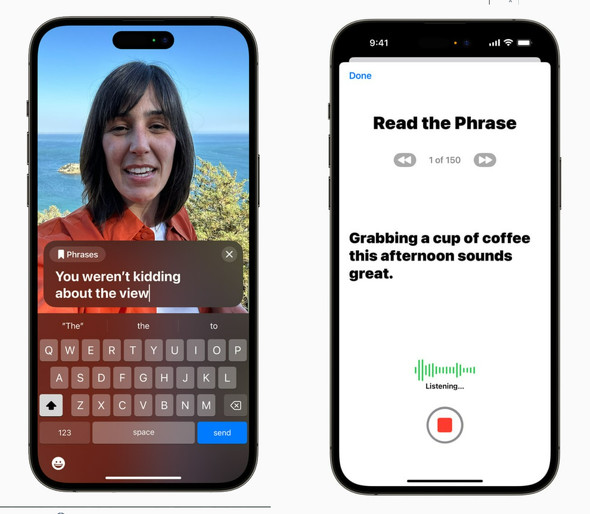

「Live Speech」は、iPhone、iPad、Macで使えるテキストを音声に変換するツール。電話やFaceTime、リアルな対面での会話で、入力したテキストをユーザーの代わりに読み上げる。すぐに使えるフレーズを複数保存しておくこともできる。

声を出せなくなる前に自分の声を登録し、Live Speechに使える「Personal Voice」

「Personal Voice」は、Live Speechに使う音声を、自分の(かつての)声にできる機能。ALS(筋萎縮性側索硬化症)など、将来会話能力を失うリスクのある人が、Live Speechに自分の声を登録しておき、その声で会話できるようにする。

ユーザーは、Appleが用意した一連のテキストを読み上げることでPersonal Voiceを作成できる。所要時間は約15分間。iPhoneまたはiPadで録音する。この機能は端末上の機械学習機能を使うため、音声などの情報はプライベートで安全という。

残念ながら当面は英語でのみ利用可能だ。

認知障害のある人のiPhoneやiPadを使いやすくする「Assistive Access」

「Assistive Access」や、認知障害のある人々とその支援者からのフィードバックを反映させた、写真や音楽、通話などを使いやすくする機能。「写真」「メッセージ」「カメラ」「ミュージック」などのアプリのユーザーインタフェースを使いやすくする。また、電話とFaceTimeを1つの通話アプリに統合する。

「拡大鏡」に写したテキストを指差すと読み上げる「Point and Speak」

「Point and Speak」は、Appleが以前から提供しているiPadとiPhoneの拡大鏡アプリを使った視覚障害者向けのツールだ。例えば電子レンジなどの操作ボタンのラベルを拡大鏡で写しながらボタンに指を置くと、各ボタンのテキストを音声で読み上げる。この機能は、カメラ、LiDRスキャナー、端末内の機械学習機能を組み合わせて実現する。この機能は日本語でも利用できるようになる見込みだ。

Appleはこの他にも次期OSで利用可能になるアクセシティビティ機能をプレスリリースで紹介している。

関連記事

関連リンク

からの記事と詳細 ( Apple、AI採用障害者支援ツールを多数発表 失う前に登録した声で話せる「Personal Voice」など - ITmedia NEWS )

https://ift.tt/4NTaEIr

科学&テクノロジー

No comments:

Post a Comment